Politik und Social Media

Filterblasen auf Tiktok – das sagen die Zahlen

Auf Tiktok sieht jeder nur, was ihm oder ihr gefällt. Ist das wirklich so? Die Daten von gut 700 Usern zeigen erstmals detailliert, wie dicht die politischen Filterblasen sind.

© Pichlmaier

Die einen so, die anderen so: Linke und rechte Milieus kriegen auf Tiktok nur wenig voneinander mit.

Von Simon Koenigsdorff und Jan Georg Plavec

Dass Filterblasen in sozialen Medien ein Problem sind, befand schon vor fast zehn Jahren Angela Merkel. Im November 2016 beklagte sie im Bundestag das Phänomen der „Meinungsverstärker durch Algorithmen“ – dass Internetplattformen ihren Nutzern vor allem jene Beiträge zeigten, die deren eigene Meinung bestätigten. Solche Phänomene müsse man, „wo notwendig, auch regeln“.

Damals war Facebook noch das wichtigste Netzwerk. Heute ist es Tiktok, jedenfalls für Unter-40-Jährige. Die Filterblasen sind weiterhin ein Thema. Im Sommer 2023 beklagte Merkels Nachfolger Olaf Scholz im Interview mit der „Süddeutschen Zeitung“: Es sei „der Fluch der sozialen Medien: dass wir es uns gemütlich in unseren Blasen einrichten können, wo wir nur Dinge vorgeschlagen bekommen, die zu dem passen, was wir schon immer richtig fanden“, so Scholz.

Erstmals detaillierte Daten zu Filterblasen

Was in der Theorie einleuchtet, wurde in der Praxis selten untersucht – weil Daten fehlen, insbesondere solche echter Nutzer. Schicken Tiktok und Co. ihre Nutzer wirklich in Filterblasen? Um diese Frage zu beantworten, braucht es die Daten echter User. Mit dem Projekt „Dein Feed, deine Wahl“ sammelte unsere Zeitung gemeinsam mit dem Bayerischen Rundfunk, dem Weizenbaum-Institut und der Uni Zürich sie in Form von sogenannten Datenspenden ein. Fast 700 Tiktok-User luden unter anderem sämtliche Videos hoch, die sie im Bundestagswahlkampf 2025 auf Tiktok gesehen haben. Außerdem teilten sie mit, wen sie wählen wollen. Journalisten und Forscher analysierten wiederum, welche Politiker und Parteien die Teilnehmer auf Tiktok gesehen haben.

Weil unter den Teilnehmern deutlich mehr Anhänger von Linken, Grünen und SPD waren, haben wir die Analyse auf diese Gruppe beschränkt und die Videos von CDU-, FDP- und AfD-Politikern in ihren Tiktok-Feeds gezählt. Das Ergebnis: Durchweg sahen mindestens 80 Prozent der links oder grün wählenden Tiktok-Nutzer während des Wahlkampfs höchstens fünf Videos von Politikern rechts der Mitte. Höchstens jeder Fünfte kam auf eine zweistellige Zahl solcher Videos.

Der Anteil politischer Inhalte auf Tiktok ist ohnehin gering, wie eine weitere Analyse der Daten ergeben hat, nur etwa ein Prozent der Videos in den Feeds stammt überhaupt von Parteien und Politikern. In der Gegenprobe sahen mindestens drei von vier Usern eine zweistellige Zahl Videos von Politikern aus dem linken Spektrum – in der Regel mindestens zwanzig, vielfach auch weit mehr als hundert Videos mit linken oder grünen Inhalten. Ein Beweis für Filterblasen?

„Der Algorithmus bei der Arbeit“

Über den Begriff könne man sich streiten, eine feste Definition gebe es nicht, sagt der Datenwissenschaftler Richard Schwenn vom Berliner Thinktank Polisphere. Vor allem sehe man „den Algorithmus bei der Arbeit“. Aus den Zahlen spreche „ein hoch entwickelter Empfehlungsmechanismus“, der Tiktok-Usern passende Inhalte anzeigt. Im Fall der Politikvideos eben überwiegend solche, die ihrer politischen Haltung entsprechen.

Insofern zeigen die Daten auch, wie gut der Tiktok-Algorithmus die Nutzer einschätzen kann. Anhand der betrachteten Inhalte verortet er sie in der Nähe von Usern, die ähnliche Clips gesehen haben. Weil links oder grün wählende Tiktok-Nutzer andere Inhalte ansehen als solche rechts der Mitte, bekommen diese politischen Milieus in aller Regel unterschiedliche politische Inhalte zu sehen. Das bedeutet jedoch nicht, dass die Nutzer von parteipolitischen Videos überschwemmt würden, nicht einmal mitten im Bundestagswahlkampf – auch hier dominieren selbst bei den politisch sehr interessierten Usern andere Themen.

Tiktok bilde ab, was schon in Prä-Internetzeiten typisch gewesen sei, findet Martin Fuchs, ein Kommunikationsexperte, der Politik in den sozialen Medien seit vielen Jahren beobachtet: „Die wenigsten Menschen, die ich kenne, lesen sowohl die linke taz als auch die konservative FAZ.“ Filterblasen seien gewissermaßen in der Psychologie der Menschen angelegt, ergänzt Richard Schwenn. Der Tiktok-Algorithmus nutze das aus.

Was Filterblasen eigentlich bewirken

Ihn stört etwas Anderes: „Dass Plattformen wie Tiktok sich als öffentlicher Raum inszenieren, als Forum. Dabei ist man bloß in einem vom Algorithmus kuratierten Raum für einen selbst.“ Das werde spätestens dann zum Problem, wenn die schnell wachsende Videoplattform Tiktok so wie anderswo auf der Welt für viele zur wichtigsten Nachrichtenquelle wird. „Weil auf Tiktok Meinung dominiert, kriegen Personen je nach Filterblase von derselben Nachricht völlig unterschiedliche Einordnungen ausgespielt“, kritisiert Schwenn.

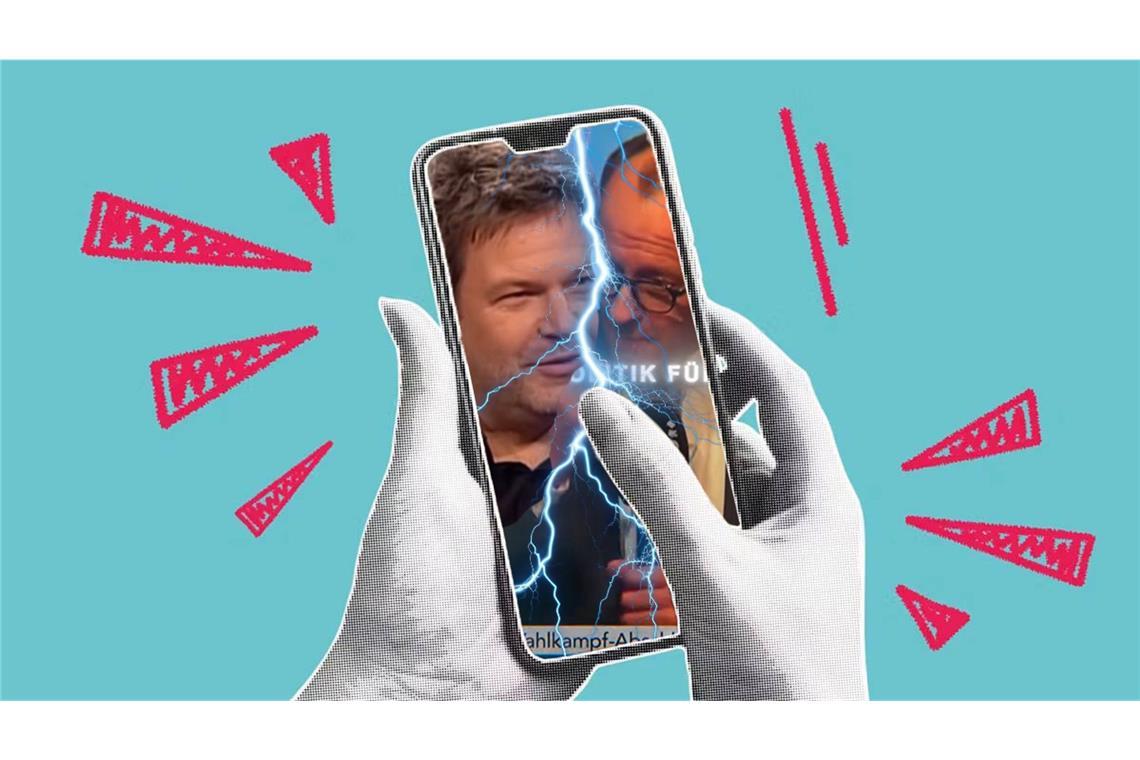

Meinung statt Information: Auf Tiktok funktioniert, was radikal subjektiv oder weltanschaulich ist, was Emotionen auslöst und zur Reaktion auffordert. Der Algorithmus misst genau, wie lange User ein Video sehen, er erfasst Reaktionen wie den Klick auf „Gefällt mir“ oder die auf Tiktok mögliche Gegenrede unter Einbindung des Originalclips. Je mehr Interaktion, desto mehr User sehen ein Video.

Erfahrene Tiktoker wissen, welche Art von Video viele Interaktionen erzeugt – und wie man damit auch politische Milieugrenzen überwinden kann. Das gelingt am ehesten mit provokativen Clips, die bei Usern der politischen Gegenseite Spott oder wütende Widerrede anregen. Es kann aber auch schiefgehen.

Als Beispiel dient ein 13 Sekunden langer Clip des Berliner AfD-Bundestagsabgeordneten Götz Frömming, der den Linke-Wählern in der Datenspende relativ häufig angezeigt wurde. Ein Kinderreporter mit ARD-Mikro fragt Alice Weidel, für welche Partei sie sei. Auf Weidels korrekte Antwort („Bei der AfD“) sagt der Junge „Mit denen darf ich nicht reden, hat meine Mama gesagt. Tschüss!“ und lässt sie verdutzt stehen. Weidel sagt einigermaßen bedröppelt: „Du musst doch nicht immer alles glauben, was man dir erzählt.“

@goetzfroemming #aliceweidel #nurdieafd #afdwählen ♬ Originalton - Dr. Götz Frömming

In den Kommentaren finden sich Pro-AfD-Kommentare ebenso wie solche, die den Jungen loben („Die Mutter ist direkt sympathisch“ oder „Gut erzogenes Kind“). Die Anti-AfD-Kommentare kommen teils auf Zehntausende „Gefällt-mir“-Herzen und belegen, dass der Algorithmus das Video auch etlichen politisch links stehenden Tiktok-Usern angezeigt hat.

Nicht nur Politiker und Parteien veröffentlichen auf Tiktok politischen Content. Nicht offizielle Konten verbreiten Talkshow-Ausschnitte oder andere Inhalte und bestimmten Parteien oder politischen Richtungen nahestehende Influencer suchen auf ihre Weise den Weg in eine breitere Internetöffentlichkeit. Dieses digitale Vorfeld erreicht auf Tiktok größere Reichweiten als Politiker und Parteien, wie die Analyse der Nutzerdaten zeigt. Das gilt auch für rechte Inhalte in den Feeds linker User: von AfD-, CDU- und FDP-Politikern gepostete Videos finden sich dort (noch) seltener als Videos aus dem rechten Vorfeld. Ein vielfältiges Bild von politischen Angeboten sieht anders aus.

Tiktok regulieren, aber wie?

Muss man das einfach hinnehmen oder kann man es, wie Angela Merkel vor mittlerweile fast zehn Jahren vorschlug, auch regulieren? Tatsache ist: Der von der EU beschlossene und im Frühjahr 2024 in Kraft getretene Digital Services Act reguliert Plattformen wie Tiktok oder Facebook und schreibt beispielsweise Transparenzpflichten vor. Die EU-Kommission hat auf dieser Grundlage bereits festgestellt, dass Tiktok nicht ausreichend darlege, wer auf der Plattform mit welchen Inhalten Werbung treibt.

Regeln gegen Filterblasen oder für ein ausgewogenes inhaltliches Angebot finden sich in dem EU-Gesetz nicht. Warum eigentlich? „Es ist fast unmöglich, europaweit zu konkretisieren, was ein ausgewogenes Angebot darstellt“, glaubt Richard Schwenn. Zumal Plattformen wie Tiktok dafür überhaupt erst die bei ihnen hochgeladenen Inhalte vollständig verstehen müssten. Zwar versucht Tiktok, alle Videos in Kategorien einzusortieren, auch solche mit gesellschaftlichen Themen.

Das gelingt aber mehr schlecht als recht – auch, weil es keine klare Abgrenzung gibt. Muss in einem „politischen“ Video ein Politiker auftauchen? Oder sind auch Beiträge, die sich für ein traditionelles Rollenbild der Frau, gegen Autofahren oder für die Rechte von Geflüchteten aussprechen, politisch? Die Diskussion darüber „würde den Raum aufmachen für eine riesige, politisch aufgeladene Diskussion“, glaubt Richard Schwenn.

Auch der Bremer Kommunikationsforscher Christian Katzenbach glaubt nicht an solche Vorschriften für Tiktok und Co. Zwar sehe er „auf jeden Fall dysfunktionale oder für das Gemeinwohl riskante Entwicklungen“, sagte er im Mai bei einer Expertendiskussion. „Aus demokratietheoretischen Perspektiven“ solle man aber nicht zu stark eingreifen. Immerhin ermöglicht die EU-Gesetzgebung Forschern einen Zugang zu nicht-öffentlichen Daten sehr großer Plattformen wie Tiktok – jedenfalls solange sich damit Risiken etwa für „die gesellschaftliche Debatte“ oder für „Wahlprozesse und die öffentliche Sicherheit“ erforschen lassen, so der Gesetzestext. Von Oktober an können Forscher über eine bei der Bundesnetzagentur angesiedelte Koordinationsstelle Daten anfordern. Zudem müssen die Plattformen in ihren AGB die wichtigsten Parameter in ihren Empfehlungssystemen darlegen.

Daten für Forscher, Rechte für die User: Große Plattformen müssen den Nutzern die Möglichkeit einräumen, Empfehlungssysteme zu wechseln – also beispielsweise nur Beiträge von Nutzern zu sehen, denen man aktiv folgt. Denkbar, sagt Richard Schwenn, wäre ein nach anderen Kriterien funktionierender Algorithmus, der beispielsweise als besonders vertrauenswürdig markierte Inhalte bevorzugt: „I trust“ statt „I like“. Oder ein Algorithmus, dessen Kriterien User selbst anpassen können.

Ob dann freilich Wähler der Linken oder der Grünen einstellen, möglichst viele Videos von AfD- oder CDU-Politikern zu sehen? Eher unwahrscheinlich. Es steht also zu vermuten, dass Menschen auch weiterhin auf Tiktok in Filterblasen abtauchen. Dann wäre es aber zumindest ihre Entscheidung und nicht die des Algorithmus.

Bislang größte Tiktok-Recherche mit echten Userdaten